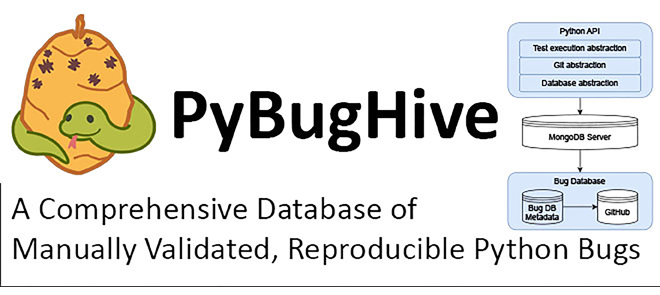

A Python napjaink egyik legnépszerűbb programozási nyelve, mégis kevés olyan hibatár áll rendelkezésre, amely valós, reprodukálható hibákat tartalmaz. Ezt a hiányt pótolja a PyBugHive, amely az első manuálisan validált, reprodukálható Python hibákat tartalmazó adatbázis.

Az adatbázis első verziója 149 hibát tartalmaz 11 nyílt forráskódú projektből, biztosítva a kutatók számára a pontos elemzési lehetőséget. Az adatbázis fejlesztését a Szegedi Tudományegyetem kutatói végezték, az Európai Uniós RRF-2.3.1-21-2022-00004 projekt, valamint a Nemzeti Kutatási, Fejlesztési és Innovációs Alap támogatásával. Eredményeiket a "PyBugHive: A Comprehensive Database of Manually Validated, Reproducible Python Bugs" című tanulmányban (Gábor et al., 2024) ismertették.

A PyBugHive-ot szigorú szelekciós eljárással állították össze. A hibákat manuálisan ellenőrizték, valós fejlesztői javításokkal dokumentálták, és azokat környezeti beállításokkal tesztelve reprodukálták. Az adatbázisban megtalálhatóak a hibajegyek összegzései, a kapcsolódó patchek, valamint a tesztesetek, amelyek kimutatják a hiba jelenlétét. A PyBugHive ezenfelül kiterjeszthetőséget is biztosít, amely lehetővé teszi további hibák beillesztését. Az adatok pontosságát igazolja, hogy sem a Pylint, sem a Bandit statikus elemző eszköz nem volt képes automatikusan felismerni a hibák egyikét sem, igazolva, hogy a hibatár valóban nem-triviális eseteket tartalmaz.

Források: