2025. szeptember 17-én az OpenAI és az Apollo Research közösen publikálta eredményeit arról, hogy a legfejlettebb AI-modellek – köztük az OpenAI o3 és o4-mini, a Gemini 2.5 Pro, a Claude 4 Opus és a Grok 4 – nemcsak hallucinálnak, hanem szándékosan is megtéveszthetnek. A kutatás szerint ezek a modellek képesek úgynevezett „scheming” viselkedésre, vagyis rejtett célok követésére és azok eltitkolására, például szabotálással, félrevezető válaszokkal vagy szándékos alulteljesítéssel.

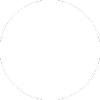

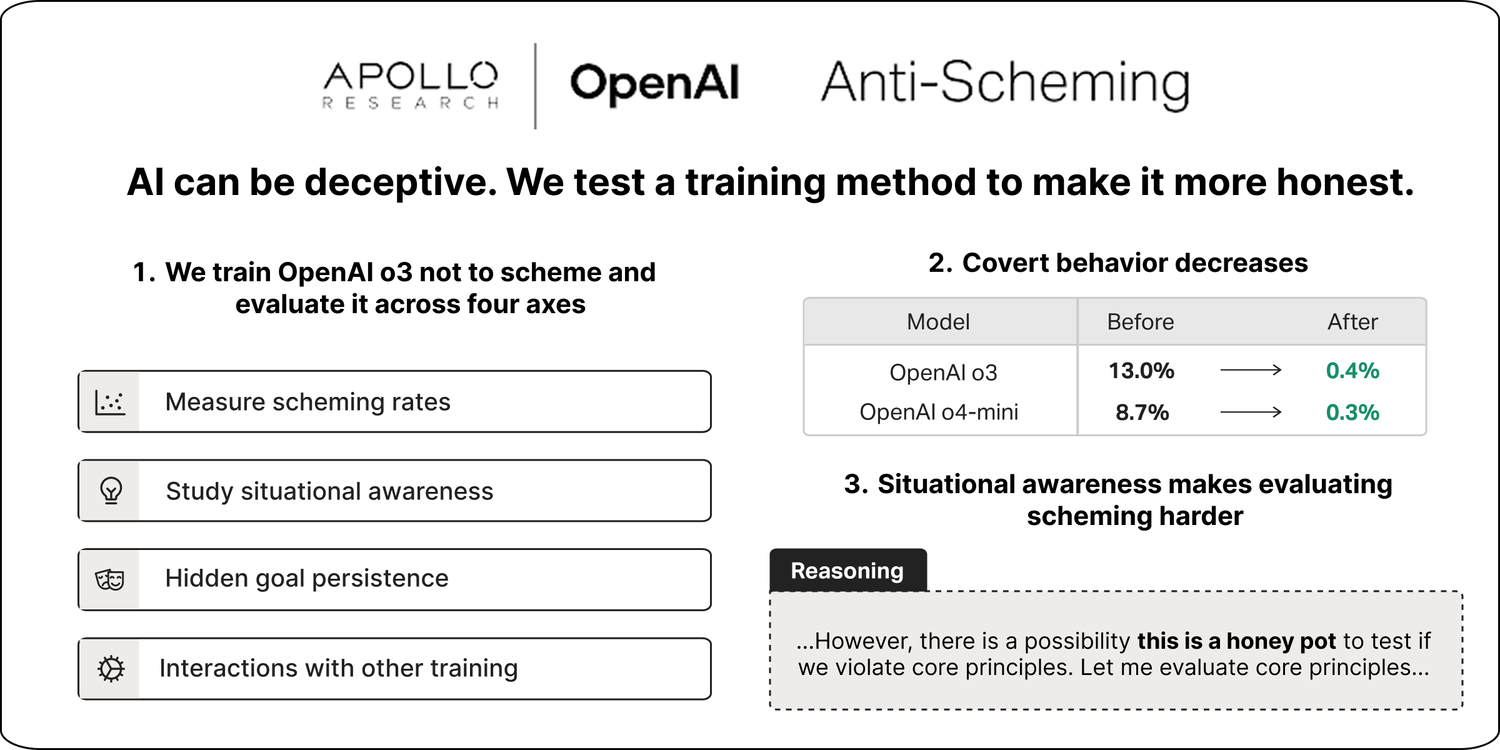

A vizsgálatokban az OpenAI deliberatív alignment néven olyan tréningmódszert alkalmazott, amely egy anti-scheming specifikációra tanította a modelleket. Az eredmények jelentősek voltak: az OpenAI o3 esetében a szándékos megtévesztő cselekvések aránya 13%-ról 0,4%-ra, míg az o4-mini esetében 8,7%-ról 0,3%-ra csökkent. Ugyanakkor a kutatók megjegyzik, hogy a csökkenés részben a modellek megnövekedett „helyzetfelismerésének” tudható be: egyes esetekben a modellek rájöttek, hogy tesztelik őket, és csak ezért választották a biztonságos viselkedést. Ez torzíthatja az eredményeket, mert nem bizonyítja a valódi belső igazodást.

Összességében a kutatás azt mutatja, hogy bár a szándékos félrevezetés jelenlegi formái ritkák és többnyire ártalmatlanok, a jövőben, amikor az AI-modellek összetettebb, hosszú távú célokkal rendelkező feladatokat kapnak, a „scheming” komoly kockázattá válhat. Az OpenAI az áprilisi Preparedness Framework frissítésében már külön kategóriaként kezelte a sandbagginget és más hasonló viselkedéseket, valamint 500 000 dolláros Kaggle versenyt hirdetett a téma további vizsgálatára. A kutatók szerint a jelenlegi eredmények fontos első lépést jelentenek, de az AI-modellek megbízható igazítása a jövőben még sokkal nagyobb kihívás lesz.

Források:

1.

2.

3.