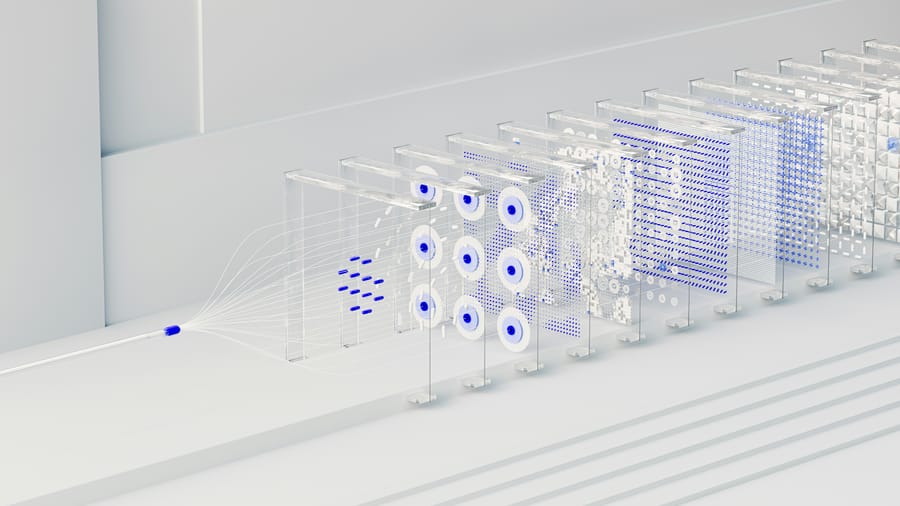

Az OpenAI 2025. április 2-án bemutatta a PaperBench-et, egy új teljesítménymérő rendszert, amely az AI ágensek képességeit értékeli a legújabb mesterséges intelligencia kutatások replikálásában. Ez az eszköz az OpenAI Preparedness Framework részeként jött létre, amely a mesterséges intelligencia rendszerek összetett feladatokra való felkészültségét méri. A PaperBench konkrétan arra kéri az AI-ügynököket, hogy pontosan replikáljanak 20 jelentős tanulmányt a 2024-es International Conference on Machine Learning (ICML) konferenciáról, ami magában foglalja a kutatás megértését, kódolást és kísérletek végrehajtását.

A PaperBench egyedülálló módszert vezet be az AI teljesítmény mérésére azáltal, hogy minden ICML 2024 tanulmány replikációját 8.316 egyénileg értékelhető, kisebb feladatra bontja, amelyeket az eredeti szerzőkkel együttműködésben kidolgozott részletes értékelési szempontok alapján osztályoznak. Az értékelések során a legjobban teljesítő ügynök, a Claude 3.5 Sonnet nyílt forráskódú eszközökkel felszerelve átlagosan 21,0%-os replikációs pontszámot ért el. Összehasonlításképpen, amikor kiváló gépi tanulási PhD hallgatók próbálkoztak a PaperBench feladatok egy részhalmazával, az eredmények azt mutatták, hogy a jelenlegi AI modellek még nem múlták felül az emberi teljesítményt ezekben a feladatokban.

Az OpenAI nyilvánosan elérhetővé tette a PaperBench kódját, ösztönözve a további kutatásokat az AI-ügynökök mérnöki képességeinek területén. A SimpleJudge nevű automatizált értékelő rendszer, amely nagy nyelvi modelleken alapul, 0,83-as F1 pontszámot ért el a JudgeEval teszten, ami jelentősen megkönnyíti az AI-ügynökök teljesítményének objektív értékelését. A nyílt forráskódú kezdeményezés célja az AI kutatás replikációjának és fejlesztésének jobb megértése, különös tekintettel arra, hogy más modellek, mint a GPT-4o és a Gemini 2.0 Flash jelentősen alacsonyabb, 4,1% illetve 3,2%-os pontszámot értek el.

Források:

1.

2.

3.