A 2025. június 26-án hivatalosan kiadott Gemma 3n jelentős fejlesztéseket tartalmaz, amelyek kifejezetten a mobilkészülékeken való AI futtatást célozzák. A multimodális modell natívan támogat kép-, hang-, videó- és szöveges bemeneteket, és két méretben érhető el: az E2B (5 milliárd paraméter) és az E4B (8 milliárd paraméter), amelyek mindössze 2GB, illetve 3GB memóriával működnek.

A Gemma 3n középpontjában több úttörő technológia áll, beleértve a MatFormer (Matryoshka Transformer) architektúrát, amely lehetővé teszi a fejlesztők számára kisebb almodellek kinyerését vagy a modell méretének dinamikus beállítását. A Per-Layer Embeddings (PLE) technika 46%-kal csökkenti a szükséges paraméterek számát, míg a KV Cache Sharing 2x-es javulást eredményez a prefill teljesítményben a Gemma 3 4B-hez képest. Az új MobileNet-V5 látórendszer akár 60 képkockát is feldolgozhat másodpercenként egy Google Pixel készüléken, ami 13-szoros gyorsulást jelent kvantálással. A beépített hangelemző rendszer a Universal Speech Model alapján lehetővé teszi a készüléken történő beszédfelismerést és beszédfordítást, jelenleg 30 másodperces hangklipekre korlátozva.

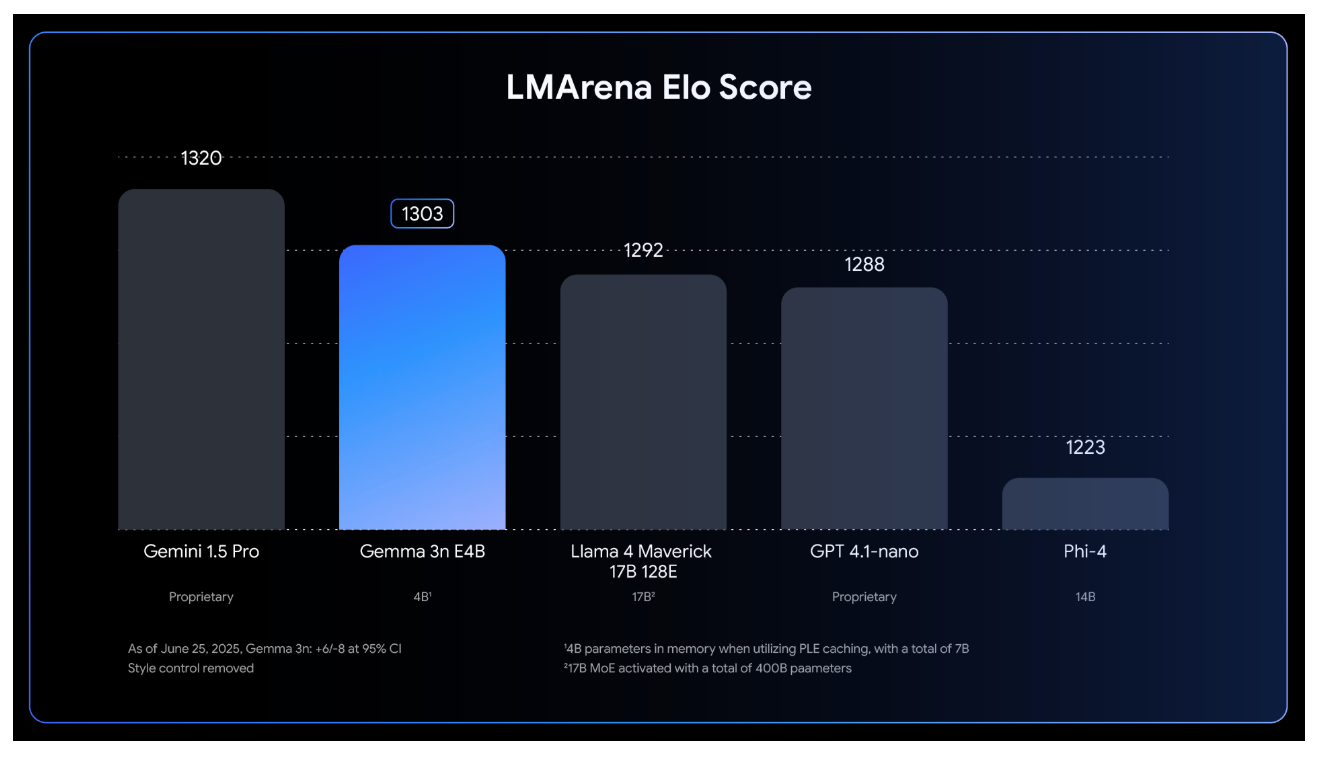

A Gemma 3n az LMArena pontszámban több mint 1300-at ért el, ami az első ilyen eredmény egy 10 milliárd paraméternél kisebb modellnél. A modell 140 nyelvet támogat szövegben és 35 nyelvet multimodális megértésben. Az eredeti Gemma modellcsalád már 160 millió letöltést ért el, és a Google aktívan támogatja az ökoszisztémát a fejlesztők számára, beleértve a Hugging Face Transformers, llama.cpp, Ollama és más eszközöket. A Google elindította a Gemma 3n Impact Challenge-t is, amely 150.000 dolláros díjat kínál a platformon épített valós alkalmazásokért, tovább ösztönözve a fejlesztői közösséget.

Források:

1.

2.

3.