A kínai DeepSeek mesterséges intelligencia laboratórium 2026. január 1-jén közzétett egy tanulmányt, amelyben bemutatják a Manifold-Constrained Hyper-Connections (mHC) nevű új architektúrát. Ezt a megoldást az AI-modellek teljesítményének javítására és a tanítási költségek minimalizálására tervezték. A tanulmányt, amelynek társszerzője a DeepSeek alapító-vezérigazgatója, Liang Wenfeng is, az AI-modellek fejlesztésének potenciális mérföldköveként emlegetik.

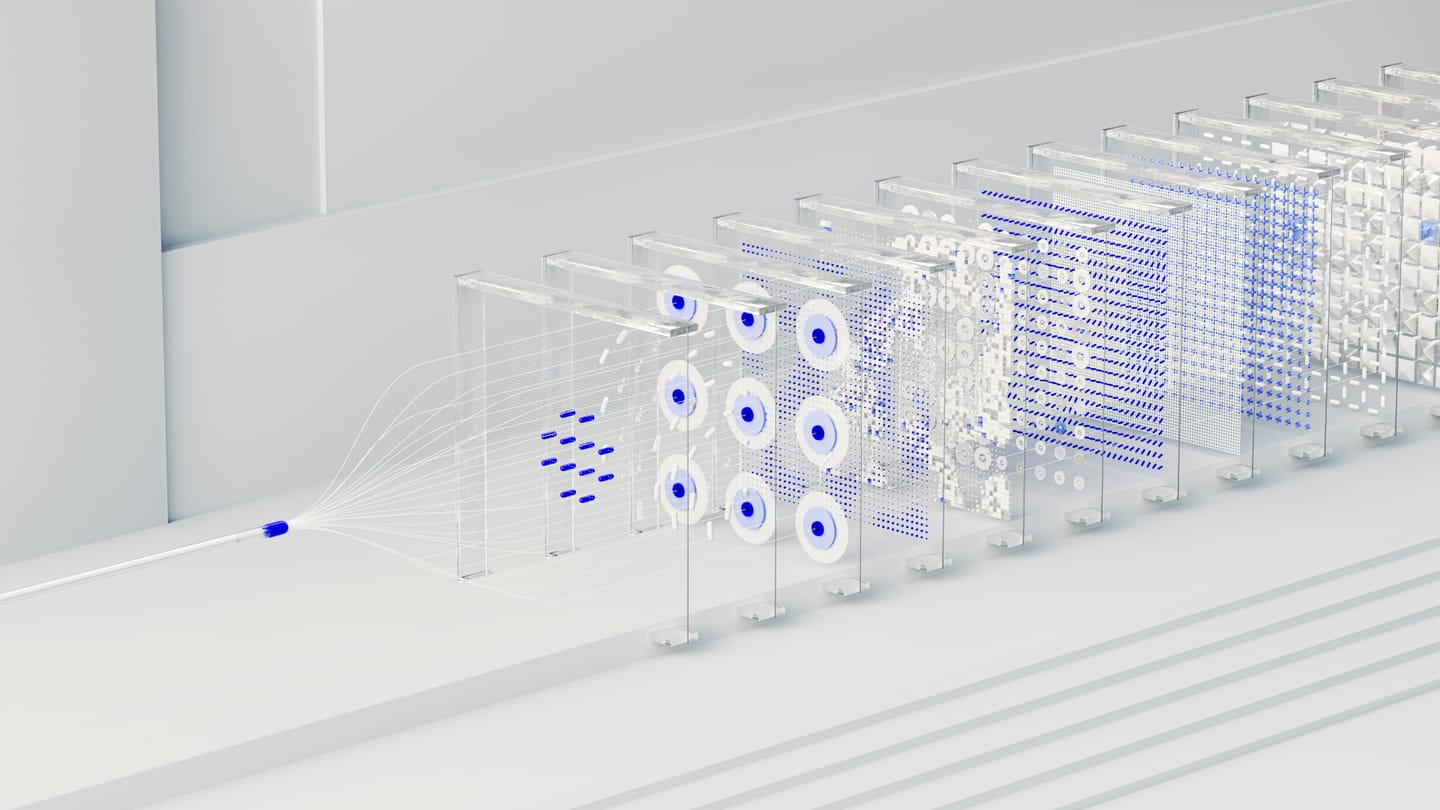

Az mHC architektúra a nagy nyelvi modellek alapjául szolgáló hagyományos maradék-hálózatok (ResNet) továbbfejlesztése, amely jól szemlélteti a kínai startup folyamatos törekvését arra, hogy korlátozott számítási erőforrások mellett is nagy teljesítményű modelleket képezzenek. Belső tesztek során a DeepSeek megállapította, hogy az mHC mindössze 6,27%-os hardveres többletköltséget okoz. A DeepSeek 19 kutatója 3 milliárd, 9 milliárd és 27 milliárd paraméteres modelleken tesztelte az mHC-t, és úgy találták, hogy az architektúra skálázható anélkül, hogy jelentős számítási terhet jelentene. A DeepSeek szerint az mHC-vel támogatott nagy nyelvi modellek nyolc különböző AI-benchmark teszten is jobb teljesítményt nyújtottak. Florian Brand, a németországi Trieri Egyetem doktorandusza és a kínai AI-ökoszisztéma szakértője szerint a DeepSeek tanulmányai gyakran előrejelzik a következő generációs modellek technikai irányvonalát. Az iparági várakozások szerint a DeepSeek a február közepén esedékes Holdújév környékén adhatja ki következő jelentős modelljét.

A hangcsoui székhelyű startup egy évvel ezelőtt már megdöbbentette az iparágat az R1 érvelő modelljével, amelyet szilícium-völgyi riválisai költségeinek töredékéből fejlesztett ki. A mostani bejelentés arra utal, hogy a DeepSeeknek ismét sikerült megkerülnie a számítási kapacitások okozta szűk keresztmetszeteket, és újabb ugrást érhetett el az intelligencia terén.

Források:

1. https://siliconangle.com/2026/01/01/deepseek-develops-mhc-ai-architecture-boost-model-performance/

2. https://dnyuz.com/2026/01/02/chinas-deepseek-kicked-off-2026-with-a-new1. https://siliconangle.com/2026/01/01/deepseek-develops-mhc-ai-architecture-boost-model-performance/

2. https://dnyuz.com/2026/01/02/chinas-deepseek-kicked-off-2026-with-a-new-ai-training-method-that-analysts-say-is-a-breakthrough-for-scaling/

3. https://finance.yahoo.com/news/chinas-deepseek-kicked-off-2026-071041508.html

4. https://www.scmp.com/tech/tech-trends/article/3338535/deepseek-proposes-shift-ai-model-development-mhc-architecture-upgrade-resnet

5. https://sg.news.yahoo.com/deepseek-kicks-off-2026-paper-093000536.html

6. https://www.freemalaysiatoday.com/category/business/2026/01/02/deepseek-touts-new-training-method-as-china-pushes-ai-efficiency