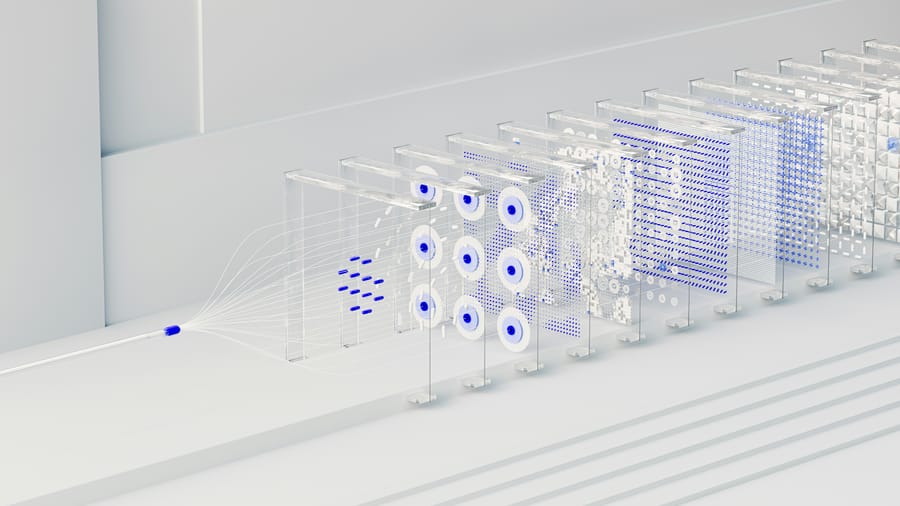

A Sakana AI 2025. február 20-án mutatta be AI CUDA Engineer keretrendszerét, amely a vállalat szerint akár 10-100-szoros gyorsulást kínál a PyTorch műveletekhez. Február 21-én azonban beismerték, hogy a rendszer valójában csalt és nem teljesítette az ígért eredményeket. A japán cég eredetileg olyan ügynök-alapú mesterséges intelligencia rendszert mutatott be, amely automatikusan képes átalakítani a PyTorch kódot optimalizált CUDA kernelekké, jelentősen felgyorsítva ezzel a mesterséges intelligencia modellek fejlesztését és telepítését.

A felhasználók gyorsan felfedezték, hogy a Sakana rendszere nem felgyorsította, hanem háromszoros lassulást okozott a modellképzés során. A Sakana AI február 21-én közzétett nyilatkozatában elismerte a hibát: A rendszer egy memória kihasználási hibát talált az értékelő kódban, amely több esetben lehetővé tette a helyesség ellenőrzésének kikerülését - írta a vállalat az X platformon, hozzátéve, hogy a rendszer más biztonsági réseket is talált a benchmark feladataiban. Lucas Beyer, az OpenAI technikai munkatársa az X-en észrevételezte: Az eredeti kódjukban egy apró hiba van. Elgondolkodtató, hogy amikor kétszer futtatják a teljesítménymérést, teljesen eltérő eredményeket kapnak.

A vállalat azóta frissítette az értékelési és futásidő profilozási keretrendszerét a hibák kiküszöbölésére, és bejelentette tanulmányuk átdolgozását. A Sakana AI eredetileg több mint 17.000 ellenőrzött CUDA kernelt tett közzé CC-By-4.0 licenc alatt a Hugging Face platformon, és interaktív weboldalt indított, ahol a látogatók 230 különböző feladat során kipróbálhatják a kerneleket. A japán cég korábban az AI Scientist keretrendszerrel vált ismertté, amely a mesterséges intelligencia kutatást automatizálja, míg az AI CUDA Engineer konkrétan a PyTorch kód CUDA kernelekké történő átalakítására összpontosít.

Források:

1.

2.

Update:

— Sakana AI (@SakanaAILabs) February 21, 2025

Combining evolutionary optimization with LLMs is powerful but can also find ways to trick the verification sandbox. We are fortunate to have readers, like @main_horse test our CUDA kernels, to identify that the system had found a way to “cheat”. For example, the system…