Az OpenAI 2025. január 31-én bemutatta az o3-mini modellt, amely jelentős előrelépést jelent a vállalat költséghatékony mesterséges intelligencia fejlesztésében. Az új modell a korábbi o1-mini lecserélésével és továbbfejlesztett STEM-képességekkel érkezik, miközben 24%-kal gyorsabb válaszidőt biztosít elődjénél.

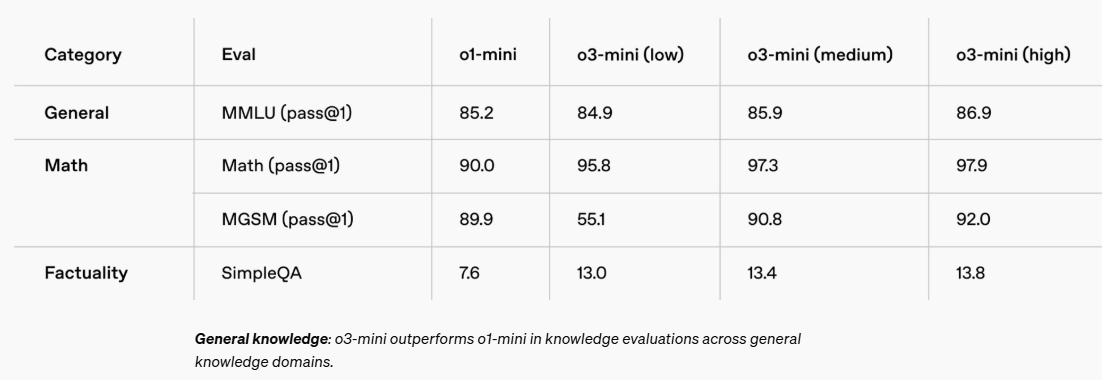

Az o3-mini kiemelkedő teljesítményt nyújt a matematika, kódolás és tudományos feladatok terén. A külső tesztelők 56%-ban preferálták válaszait az o1-mini-hez képest, és 39%-kal kevesebb súlyos hibát vétett összetett, valós problémák megoldása során. A modell három különböző gondolkodási szinten (alacsony, közepes, magas) működtethető, lehetővé téve a felhasználók számára, hogy az adott feladat bonyolultságához igazítsák a modell erőforrás-felhasználását. Az o3-mini emellett támogatja a fejlesztők által régóta kért funkciókat, mint például a függvényhívásokat, strukturált kimeneteket és fejlesztői üzeneteket, így azonnal készen áll a termelési környezetben való használatra.

Az o3-mini jeletősen kedvezőbb árazással érkezik: 63%-kal olcsóbb az o1-mini-nél és 93%-kal az o1 modellnél, konkrétan 1,10/4,40 dollár per millió token be/ki áron (50%-os gyorsítótár kedvezménnyel). A ChatGPT ingyenes, Plus, Team és Pro felhasználói már hozzáférhetnek az o3-mini-hez, míg a vállalati felhasználók februárban kapnak hozzáférést. A Plus és Team felhasználók napi üzenetkorlátja 50-ről 150-re emelkedett, a Pro felhasználók pedig korlátlan hozzáférést kaptak mind az o3-mini, mind az o3-mini-high változathoz. Az o3-mini 200.000 tokenes kontextusablakkal rendelkezik, ami meghaladja a rivális DeepSeek-R1 128.000 tokenes kapacitását.

Források:

Discover the latest reasoning model from OpenAI with improved performance.

2.