Az elmúlt időszakban jelentős előrelépés történt a nagy nyelvi modellek matematikai képességeinek terén, azonban a 2025-ös USAMO (USA Matematikai Olimpia) versenyén végzett részletes emberi értékelések szerint a jelenlegi modellek messze elmaradnak a valódi matematikai bizonyítások létrehozásában. Míg egyes benchmarkok, mint a MathArena, pozitív képet festenek az LLM-ek teljesítményéről az AIME versenyen, ahol a Gemini-2.5 Pro a legjobb emberi versenyzőkkel összehasonlítható eredményeket ért el, ezek az értékelések kizárólag a végső numerikus válaszok helyességét vizsgálták, figyelmen kívül hagyva a szigorú érvelés és bizonyítás minőségét.

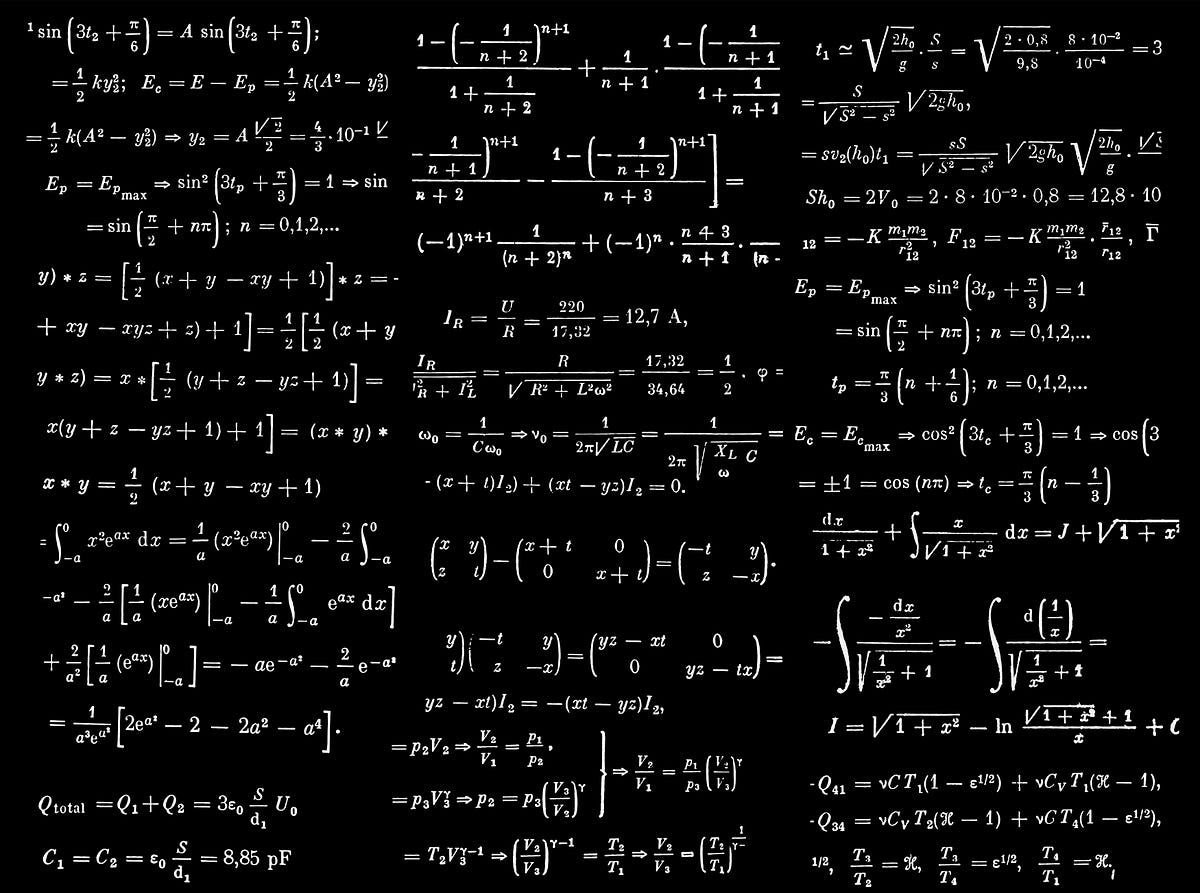

A 2025-ös USAMO hat feladatán végzett szakértői értékelés lesújtó eredményeket mutatott: a Gemini-2.5 Pro mindössze 25%-os pontszámot ért el, míg a többi modell kevesebb mint 5%-ot. Az LLM-ek matematikai érveléseinek összehasonlító értékelése című tanulmány szerint a modellek teljesítménye az IMO-szintű problémákon szintén gyenge, mindössze 3,8% (DeepSeek) és 0% (Gemini 2.0) között mozog a helyes megoldások aránya. Az értékelők azonosították a leggyakoribb hibatípusokat is, mint például a példával történő bizonyítás, ellenőrzés nélküli állítások, és helytelen tények közlése. Ahogy a kutatók megjegyezték: az LLM-ek gyakran olyan heurisztikákat, rövidítéseket és megalapozatlan találgatásokat alkalmaznak, amelyek gyakran tévútra vezetnek a szigorú érvelés helyett.

Az értékelések arra is rámutattak, hogy még amikor a modellek helyes végeredményt adnak is (ami az esetek 63,2%-ában fordult elő a DeepSeek esetében), a mögöttes érvelés általában hibás. A modellek olyan káros mintákat is mutattak, mint a nem létező források idézése, és nehezen tudták megkülönböztetni a helyes és helytelen megoldásokat. Ezek az eredmények világosan jelzik, hogy az LLM-ek olimpiai szintű matematikai képességeiről szóló állítások túlzóak, és hogy jelentős fejlesztésre van szükség az érvelési és bizonyítási képességek terén, mielőtt ezek a modellek valóban alkalmasak lennének komplex matematikai feladatok megoldására.

Források:

1.

2.

3.