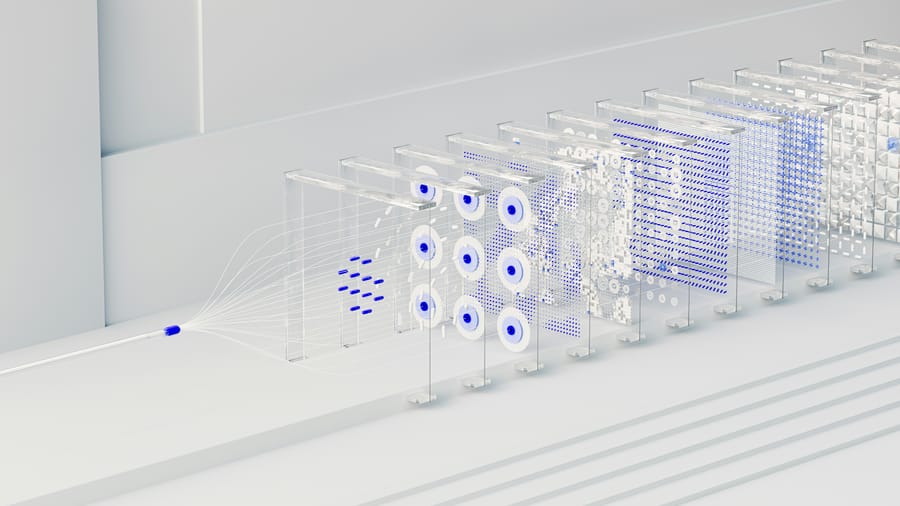

Az EuroBERT, az új többnyelvű kódoló modellcsalád jelentős előrelépést jelent a modern nyelvtechnológiában, amely 15 európai és globális nyelv hatékonyabb feldolgozását biztosítja 8.192 tokenig terjedő szekvenciákkal. 2025. március 10-én mutatták be hivatalosan az EuroBERT modellcsaládot, amelyet 5 billió tokennel képeztek ki, és három méretben (210M, 610M és 2,1B paraméter) áll rendelkezésre. A modell egyesíti a kétirányú kódoló architektúrát a dekóder modellek legújabb innovációival, jelentősen meghaladva a korábbi többnyelvű modelleket a teljesítmény terén.

Az EuroBERT jelentősen felülmúlja a hasonló technológiákat a nyelvi feldolgozási képességek terén. A kutatási eredmények szerint a modellcsalád 18 különböző típusú nyelvi feladatból 10-ben első helyezést ért el a tesztek során. A dokumentumkeresési pontossága különösen kiemelkedő: a MIRACL tesztben 92,9%-os találati arányt mutatott, ami azt jelenti, hogy csaknem minden releváns dokumentumot megtalált a keresési kérésekre. Az MLDR tesztben 66,1%-os, a Wikipedia keresési teszteken pedig 95,8%-os pontosságot ért el. Ezek a számok 5-15%-kal magasabbak, mint a jelenlegi legjobb modelleké. Nicolas Boizard, a vezető kutató szerint az EuroBERT modellek következetesen felülmúlják az alternatívákat a többnyelvű visszakeresés, osztályozás és regressziós feladatok terén, és kimagaslóan teljesítenek kódolási és matematikai feladatokban.

Az EuroBERT különleges képessége, hogy hatékonyan dolgoz fel hosszú szövegeket is. A legnagyobb, 2,1B paraméterű változat a 8.192 token hosszúságú (kb. 15-20 oldalnyi) szövegek feldolgozásakor is mindössze 2%-os teljesítménycsökkenést mutat a rövid szövegekhez képest, míg a versenytársak, mint az XLM-RoBERTa, ugyanezen a teszten 40-50%-os teljesítményvesztést szenvednek el. A kutatók vizsgálatai szerint a kód és matematikai tartalmak 15%-kal javítják a keresési képességeket, a párhuzamos nyelvű szövegek pedig 8-10%-kal növelik mind az osztályozási, mind a keresési pontosságot. Az EuroBERT hatásának jelentőségét növeli, hogy a teljes modellcsaládot nyílt forráskódúként tették elérhetővé a fejlesztők és kutatók számára, beleértve a köztes tanítási állapotokat is.

Források:

1.

2.

3.