A DeepSeek AI 2025. március 24-én kiadta legújabb, 685 milliárd paraméteres DeepSeek-V3-0324 modelljét, amely nyílt forráskódú alternatívaként versenyez az Anthropic Claude 3.7 Sonnet modelljével. Az új modell jelentős előrelépést mutat a kódolás, matematikai feladatok és általános problémamegoldás területén, miközben MIT licenc alatt ingyenesen hozzáférhető.

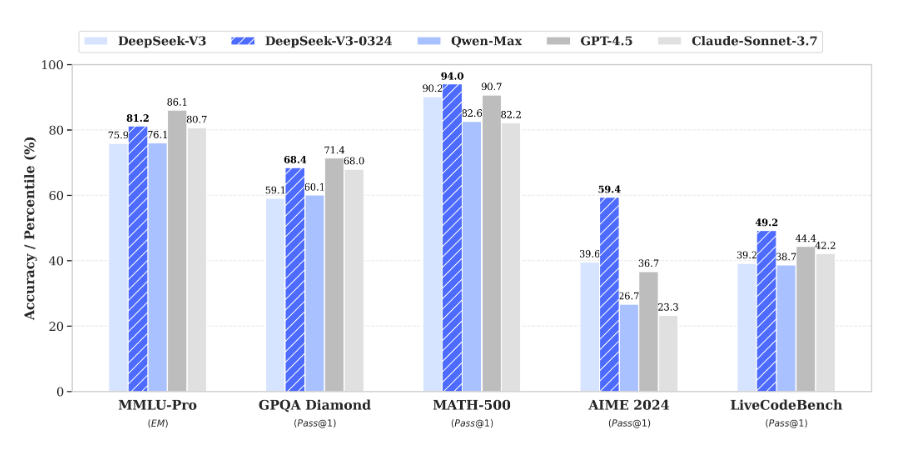

A DeepSeek-V3-0324 Mixture-of-Experts (MoE) architektúrát használ, amely tokenként csak 37 milliárd paramétert aktivál, így hatékonyan működik korlátozott erőforrások mellett is. A benchmark eredmények lenyűgözőek: a több tantárgyat átfogó nyelvi megértést mérő MMLU-Pro teszten 75,9%-ról 81,2%-ra (+5,3 pont), a komplex általános tudást vizsgáló GPQA teszten 59,1%-ról 68,4%-ra (+9,3 pont), az orvosi kontextusokat értelmező AIME teszten pedig 39,6%-ról 59,4%-ra (+19,8 pont) javult a teljesítmény. A valós programozási feladatokat mérő LiveCodeBench teszten 39,2%-ról 49,2%-ra nőtt a pontszám, ami 10 pontos javulást jelent.

A DeepSeek-V3-0324 széles körben alkalmazható különböző iparágakban, beleértve a pénzügyi szektort (komplex elemzések és kockázatértékelés), egészségügyet (orvosi kutatások támogatása és diagnosztikai segédeszközök), szoftverfejlesztést (automatizált kódgenerálás és hibaelemzés), valamint a telekommunikációt (hálózati architektúrák optimalizálása). A modell különböző keretrendszereken keresztül elérhető, mint az SGLang (NVIDIA/AMD GPU-khoz), LMDeploy és TensorRT-LLM, továbbá 1,78–4,5 bites GGUF formátumú kvantált verziói is megjelentek, amelyek lehetővé teszik a helyi használatot akár kevésbé erős hardvereken is.

Források:

1.

2.

3.

4.