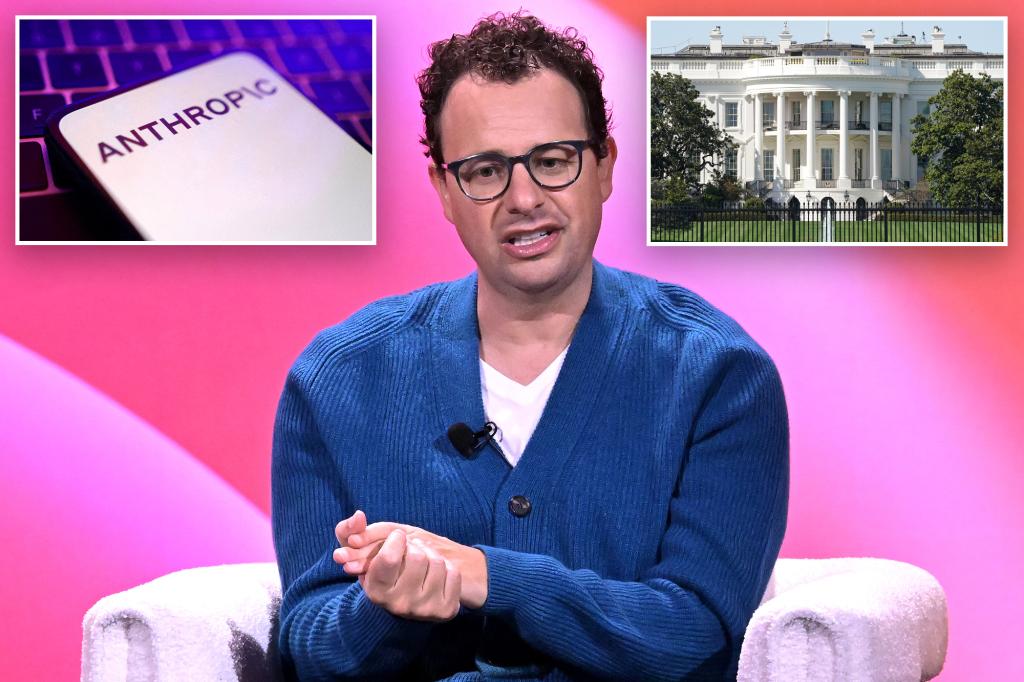

2025 szeptemberében az Anthropic közölte, hogy AI modelljeit nem engedi rendészeti vagy megfigyelési célokra alkalmazni az Egyesült Államokban, ami közvetlen vitát váltott ki a Trump-adminisztrációval. A döntés különösen figyelemre méltó, mivel a kormányzat növekvő mértékben támaszkodik AI-technológiákra a nemzetbiztonság és a rendvédelem területén, míg az Anthropic – az OpenAI egyik legnagyobb versenytársa – az etikai normákra hivatkozva elutasította ezt a felhasználási formát.

A vállalat „Constitutional AI” megközelítése a demokratikus értékek és emberi jogok tiszteletben tartására épül, és támogatóinak soraiban olyan intézmények is megtalálhatók, mint a baloldali kötődésű Ford Foundation. A Semafor szeptember 17-i jelentése szerint a Fehér Házban komoly aggodalmat keltett, hogy az Anthropic saját szabályrendszere kizárja a bűnüldözési alkalmazásokat, miközben más cégek – például a Palantir – aktívan értékesítik AI-megoldásaikat a kormányzatnak. A Gizmodo elemzése kiemeli, hogy a lépés illeszkedik az Anthropic hosszú távú stratégiájába, amely a társadalmi felelősségvállalást a gyors kereskedelmi haszon elé helyezi.

A szeptemberi fejlemények azt mutatják, hogy az AI szabályozása és etikai keretei egyre inkább politikai viták tárgyává válnak az Egyesült Államokban. Az Anthropic döntése, amely kizárja a megfigyelési célú felhasználást, egyszerre élezte ki a konfliktust a kormányzattal és állíthat fel precedenst az iparág többi szereplője számára. Hosszú távon ez hatással lehet arra, milyen feltételek mellett válhatnak az AI-modellek a közbiztonsági gyakorlat részévé, és mennyire sikerül megőrizni a demokratikus normák érvényesülését a technológia fejlesztésében.

Források:

1.

2.

3.