A 2025. március 26-án megjelent Forethought Research tanulmány szerint az AI kutatás-fejlesztés teljes automatizálása akár szoftver-alapú intelligenciarobbanáshoz vezethet. A kutatók azt vizsgálták, mi történik, amikor az AI rendszerek képessé válnak saját fejlesztési folyamataik teljes körű automatizálására, létrehozva egy visszacsatolási hurkot, ahol minden új rendszer még fejlettebb AI-t hoz létre, potenciálisan hónapokon belül.

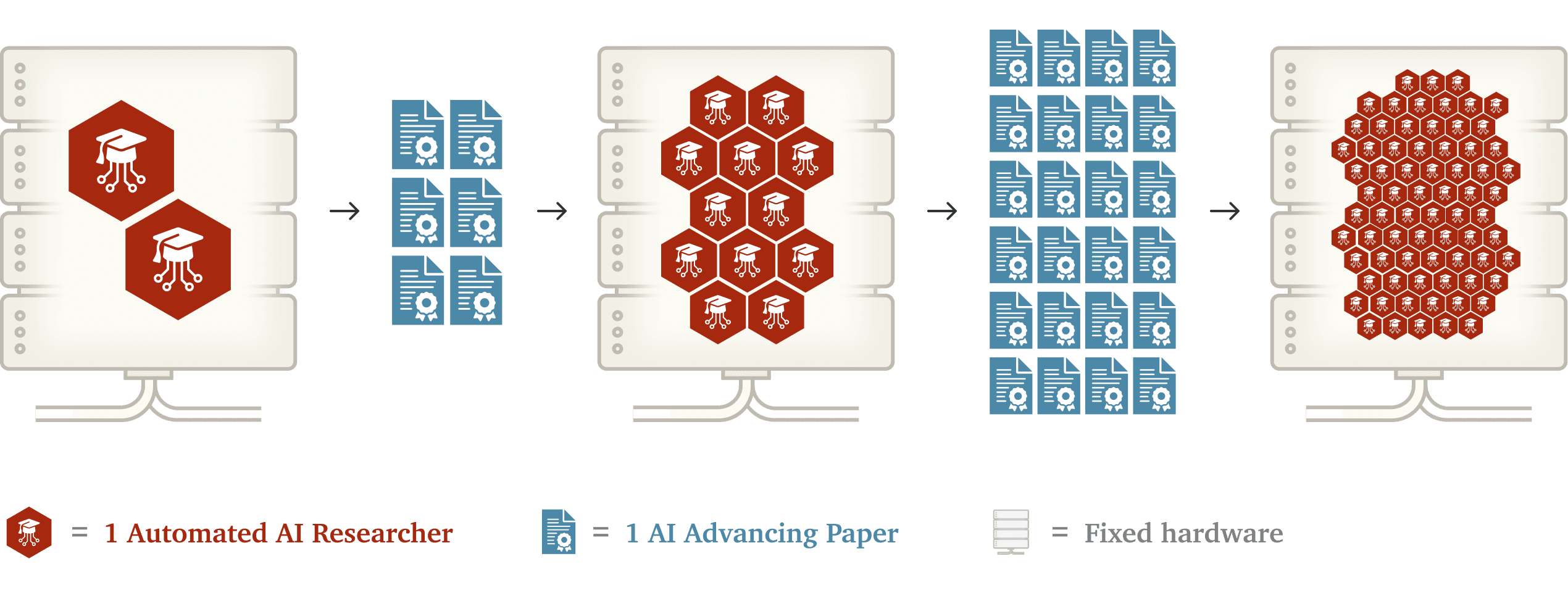

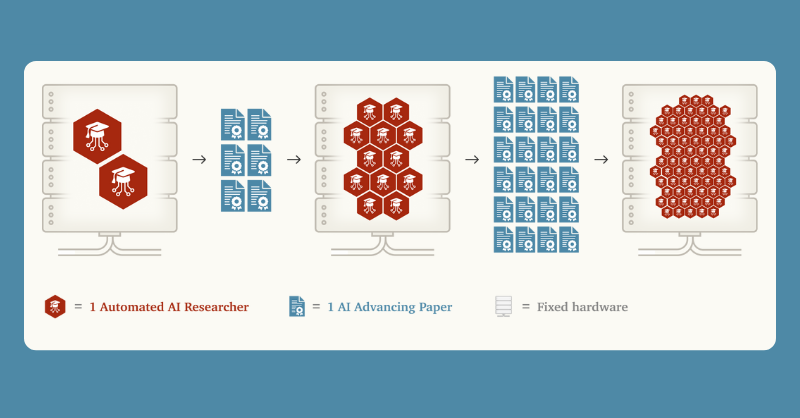

Az empirikus adatok azt mutatják, hogy az AI szoftverek hatékonysága körülbelül 6 havonta duplázódik, és ez a fejlődés valószínűleg gyorsabb, mint a kutatói erőforrások növekedési üteme. Elemzések szerint az AI eszközök jelenleg a Google teljes forráskódjának több mint 25 százalékát állítják elő automatikusan, míg az Amazonnál körülbelül 4500 fejlesztői-év munkáját és becsült 260 millió dolláros éves hatékonyságnövekedést takarítottak meg. A tanulmány két fő akadályt azonosított az AI rendszerek teljes körű fejlesztési automatizálásával (AI Systems for AI R&D Automation, ASARA) és a szoftver-alapú intelligenciarobbanással (Software Intelligence Explosion, SIE) kapcsolatban: a rögzített számítási kapacitást és az új AI rendszerek hosszú betanítási idejét. Azonban a tanulmány szerint ezek a korlátok valószínűleg nem állítják meg teljesen az SIE kialakulását, mivel a múltban az algoritmikus fejlesztések rendszeresen javították a betanítási folyamatok hatékonyságát – az AI kísérletek és a betanítási folyamatok fokozatosan gyorsabbá válhatnak, ami lehetővé teszi a folyamatos gyorsulást ezen akadályok ellenére is.

A technológiai fejlődés sebessége könnyen túllépheti a társadalom felkészülési képességeit, ezért a tanulmány konkrét biztonsági intézkedéseket javasol a szoftver-alapú intelligenciarobbanás kockázatainak kezelésére. Ha egy szoftver-alapú intelligenciarobbanás bekövetkezne, az a jelenlegi AI teljesítményének rendkívül gyors fejlődéséhez vezethetne, ami szükségessé tenné a megfelelő szabályozások előzetes kifejlesztését. A javaslatok között szerepel a szoftver fejlődésének folyamatos nyomon követése, az AI rendszerek fejlesztési képességeinek előzetes értékelése, valamint egy olyan küszöbérték meghatározása, amelyet a cégek vállalnak, hogy nem lépnek túl megfelelő biztonsági intézkedések nélkül, ezzel biztosítva a technológiai fejlődés biztonságos menetét.

Források:

1.

2.

3.