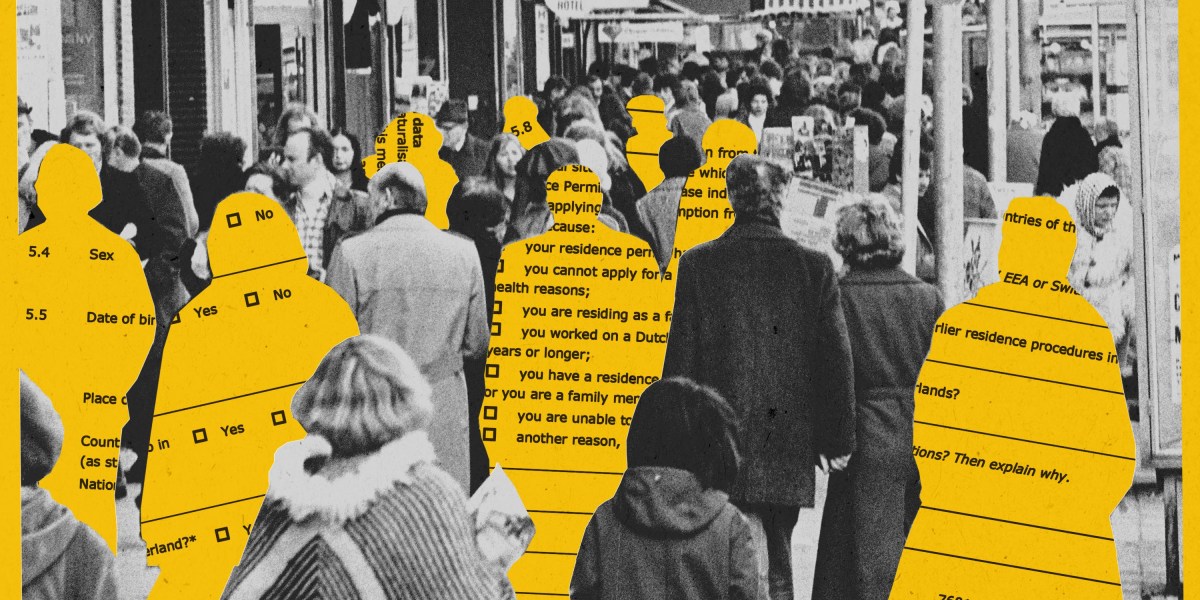

Amszterdam 2023 márciusában elindított egy 4,2 millió eurós, etikai elvek alapján tervezett AI-rendszert a szociális juttatásokkal kapcsolatos csalások felderítésére, amely a fejlesztők szerint a világ egyik legigazságosabb algoritmikus rendszere lett volna, azonban 2025 májusában a városi tanács felfüggesztette a programot, miután kiderült, hogy továbbra is hátrányosan megkülönböztette a migráns és alacsonyabb jövedelmű lakosokat. A projekt célja az volt, hogy felváltsa a korábbi SyRI nevű algoritmusos rendszert, amelyet 2020-ban a hágai bíróság betiltott, miután megállapította, hogy az sérti az emberi jogokat és diszkriminál bizonyos lakossági csoportokat. Az új rendszer kifejlesztése során a város egy 11 fős etikai bizottságot állított fel, amely különböző háttérrel rendelkező szakértőkből, köztük adatvédelmi jogászokból, etikusokból és közösségi aktivistákból állt, akik közösen dolgozták ki az AI etikai keretrendszerét.

Az amszterdami kísérlet annak ellenére bukott meg, hogy a fejlesztők számos biztosítékot építettek be a rendszerbe: kizárták a potenciálisan diszkriminatív adatokat (például irányítószámokat és neveket), átláthatósági jelentéseket készítettek, és rendszeres emberi felülvizsgálatot vezettek be. A 18 hónapos tesztelési időszak után készült független audit azonban megállapította, hogy a rendszer továbbra is 37%-kal nagyobb valószínűséggel jelölt meg marokkói és török származású személyeket potenciális csalóként, valamint 28%-kal gyakrabban célzott meg alacsonyabb jövedelmű kerületekben élő lakosokat. Marieke Koekkoek, az amszterdami egyetem jogi szakértője szerint a kudarc fő oka az volt, hogy az algoritmus továbbra is olyan történelmi adatokon alapult, amelyek már beépített elfogultságokat tartalmaztak, és amelyeket nem lehetett teljesen semlegesíteni pusztán technikai megoldásokkal.

Az amszterdami eset az AI-rendszerek méltányosságával kapcsolatos szélesebb problémákra világít rá, és jelentős hatást gyakorolt az európai szabályozásra is. Az Európai Unió AI rendelete részben az amszterdami tapasztalatok hatására szigorította meg a szociális támogatásokkal kapcsolatos AI-rendszerekre vonatkozó szabályokat, így azok most a magas kockázatú kategóriába tartoznak, amely fokozott átláthatóságot és rendszeres auditokat követel meg. A holland kormány 2025 júniusában bejelentette egy új nemzeti keretrendszer kidolgozását, amely alapján 2026-ig felülvizsgálják és potenciálisan felfüggesztik a közszférában használt összes algoritmus alapú döntéshozatali rendszert, ami a kormányzati AI alkalmazások 47%-át érinti, és ezt a példát azóta további öt európai ország, köztük Dánia és Belgium is követte.

Források: