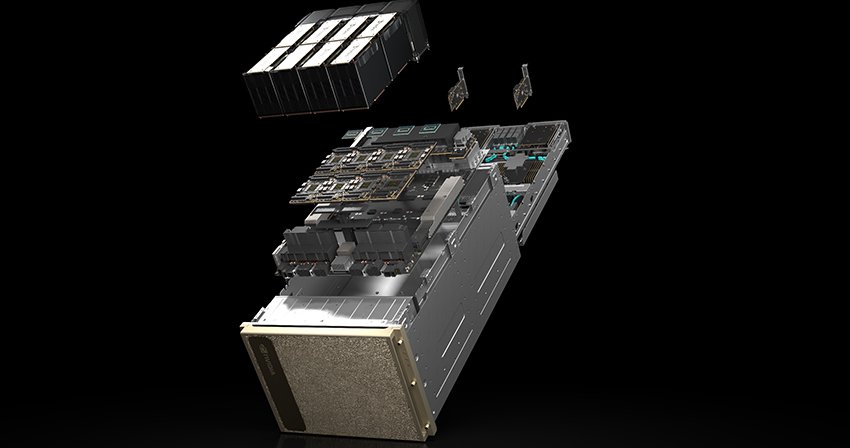

Az AI-infrastruktúra startup Parasail 2025. április 2-án hivatalosan elindította AI Deployment Network platformját, amely valós idejű, igény szerinti hozzáférést biztosít a GPU erőforrásokhoz, beleértve az Nvidia H100, H200, A100 és 4090 GPU-kat, jelentősen alacsonyabb költségek mellett, mint a hagyományos felhőszolgáltatók. A vállalat saját fejlesztésű orchestration engine-je automatikusan párosítja a munkaterheléseket a globális GPU-hálózattal, ezáltal optimalizálva a teljesítményt és csökkentve az üresjárati költségeket.

A Parasail a globális GPU-szolgáltatók erőforrásainak aggregálásával olyan GPU-flottát alakított ki, amely a vállalat állítása szerint nagyobb, mint az Oracle teljes GPU-flottája. A cég vezérigazgatója, Mike Henry szerint míg a hagyományos felhőszolgáltatók kis mennyiségű számítási kapacitással csábítják az ügyfeleket hosszú távú szerződésekbe, addig a Parasail valódi igény szerinti hozzáférést kínál rejtett korlátozások nélkül. Ez lehetővé teszi a vállalatok számára, hogy akár órák alatt telepítsenek AI-modelleket és hozzáférjenek tucatnyi GPU-hoz, minimális beállítás vagy konfiguráció mellett. A Parasail szerint az ügyfelek 2-5-szörös költségelőnyt élvezhetnek más infrastruktúra-szolgáltatókkal szemben, és akár 15-30-szoros költségcsökkentést érhetnek el az OpenAI vagy az Anthropic szolgáltatásairól való átállás esetén.

A korai felhasználók között szerepel az Elicit Research PBC, amely naponta több mint 100 000 tudományos cikket szűr AI-asszisztense segítségével, valamint a Weights & Biases, amely a népszerű DeepSeek R1 reasoning modell telepítésében használta a Parasail szolgáltatását. Henry szerint az AI-infrastruktúra jövője nem egyetlen felhőszolgáltatóban rejlik, hanem a nagy teljesítményű számítástechnikai szolgáltatók összekapcsolt hálózatában. Bár a piacon sok a versenytárs – mint a CoreWeave, a GMI Cloud, a Together Computer és a Storj Labs –, Henry nem tart a túltelítettségtől, mivel szerinte az iparág története ‘csak most kezdődik’.

Források:

1.

2.

3.